更新時間:2021-06-16 16:11:46 來源:動力節點 瀏覽1286次

使用的環境:兩臺ubuntu 14.04 64位的臺式機,hadoop選擇2.7.1版本。(前邊主要介紹單機版的配置,集群版是在單機版的基礎上,主要是配置文件有所不同,后邊會有詳細說明)

二.準備工作

2.1創建用戶

創建用戶,并為其添加root權限,經過親自驗證下面這種方法比較好。

1 sudo adduser hadoop

2 sudo vim /etc/sudoers

3 # 修改內容如下:

4 root ALL = (ALL)ALL

5 hadoop ALL = (ALL)ALL

給hadoop用戶創建目錄,并添加到sudo用戶組中,命令如下:

1 sudo chown hadoop /home/hadoop

2 # 添加到sudo用戶組

3 sudo adduser hadoop sudo

最后注銷當前用戶,使用新創建的hadoop用戶登陸。

ubuntu中默認是沒有裝ssh server的(只有ssh client),所以先運行以下命令安裝openssh-server。

sudo apt-get install ssh openssh-server

直接上代碼:執行完下邊的代碼就可以直接登陸了(可以運行ssh localhost進行驗證)

1 cd ~/.ssh # 如果找不到這個文件夾,先執行一下 "ssh localhost"

2 ssh-keygen -t rsa

3 cp id_rsa.pub authorized_keys

三.安裝過程

3.1下載hadoop安裝包

有兩種下載方式:

1. 直接去官網下載:

2. 使用wget命令下載:

wget http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

3.2配置hadoop

1.解壓下載的hadoop安裝包,并修改配置文件。我的解壓目錄是(/home/hadoop/hadoop-2.7.1),即進入/home/hadoop/文件夾下執行下面的解壓縮命令。

tar -zxvf hadoop-2.7.1.tar.gz

2. 修改配置文件:(hadoop2.7.1/etc/hadoop/)目錄下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml。

(1). core-site.xml 配置:其中的hadoop.tmp.dir的路徑可以根據自己的習慣進行設置。

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

(2). mapred-site.xml.template配置:

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

(3). hdfs-site.xml配置: 其中dfs.namenode.name.dir和dfs.datanode.data.dir的路徑可以自由設置,最好在hadoop.tmp.dir的目錄下面。

注意:如果運行Hadoop的時候發現找不到jdk,可以直接將jdk的路徑放置在hadoop-env.sh里面,具體如下:

export JAVA_HOME="/opt/java_file/jdk1.7.0_79",即安裝java時的路徑。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/hadoop/tmp/dfs/data</value>

</property>

</configuration>

配置完成后運行hadoop。

四.運行hadoop

4.1初始化HDFS系統

在hadop2.7.1目錄下執行命令:

bin/hdfs namenode -format

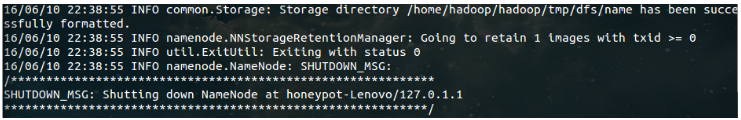

出現如下結果說明初始化成功。

NameNode 和 DataNode 守護進程在hadop2.7.1目錄下執行命令:

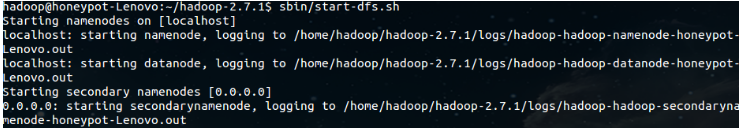

sbin/start-dfs.sh

成功的截圖如下:

若出現如圖所示結果,則說明DataNode和NameNode都已經開啟。

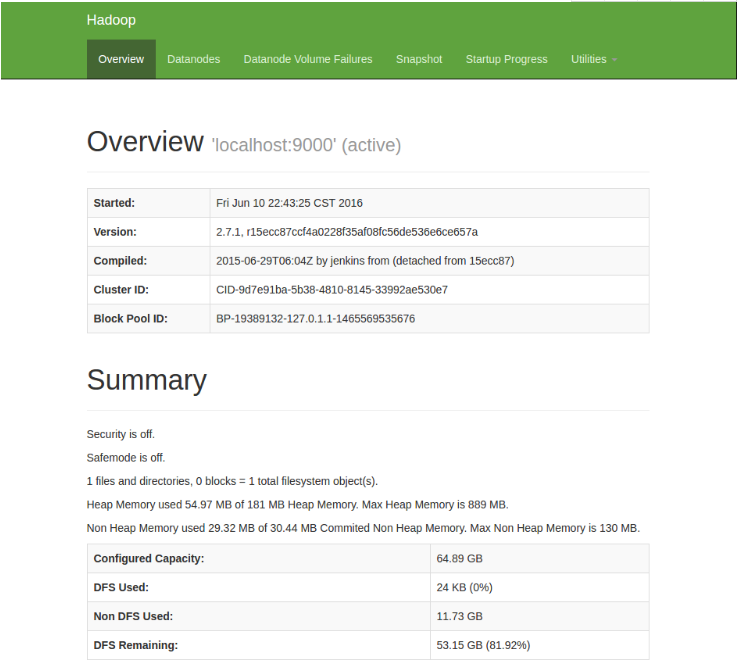

4.4查看web界面

在瀏覽器中輸入http://localhost:50070,即可查看相關信息,截圖如下

至此,hadoop的環境就已經搭建好了。

五.運行wordcount demo

1.在本地新建一個文件,里面內容隨便填:例如我在home/hadoop目錄下新建了一個haha.txt文件,里面的內容為"hello world!"。

2.然后在分布式文件系統(hdfs)中新建一個test文件夾,用于上傳我們的測試文件haha.txt。在hadoop-2.7.1目錄下運行命令:

# 在hdfs的根目錄下建立了一個test目錄

bin/hdfs dfs -mkdir /test

# 查看HDFS根目錄下的目錄結構

bin/hdfs dfs -ls /

結果如下:

3. 將本地haha.txt文件上傳到test目錄中;

# 上傳

bin/hdfs dfs -put /home/hadoop/haha.txt /test/

# 查看

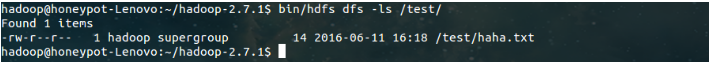

bin/hdfs dfs -ls /test/

結果如下:

4. 運行wordcount demo;

# 將運行結果保存在/test/out目錄下

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /test/haha.txt /test/out

# 查看/test/out目錄下的文件

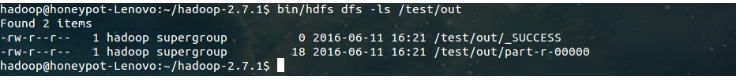

bin/hdfs dfs -ls /test/out

結果如下:

運行結果表示:運行成功,結果保存在part-r-00000中。

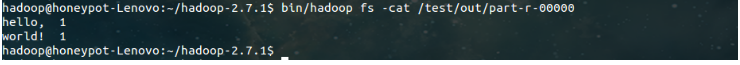

5. 查看運行結果;

# 查看part-r-00000中的運行結果

bin/hadoop fs -cat /test/out/part-r-00000

結果如下:

至此,wordcount demo 運行結束。

以上就是動力節點小編介紹的"Linux安裝hadoop集群",希望對大家有幫助,如有疑問,請在線咨詢,有專業老師隨時為您服務。

Java實驗班

Java實驗班

0基礎 0學費 15天面授

Java就業班

Java就業班

有基礎 直達就業

Java夜校直播班

Java夜校直播班

業余時間 高薪轉行

Java在職加薪班

Java在職加薪班

工作1~3年,加薪神器

Java架構師班

Java架構師班

工作3~5年,晉升架構

提交申請后,顧問老師會電話與您溝通安排學習